Hoewel veel browsers AI-functies in hun browsers integreren, is Opera zojuist de eerste browser geworden die lokale AI-modellen integreert. Opera voegt experimentele ondersteuning toe voor meer dan 150 Local Large Language Model (LLM)-varianten uit ongeveer 50 verschillende modellenfamilies aan hun Opera One-browser.

Omdat de taalmodellen lokaal zullen zijn, hoeven gebruikers zich geen zorgen te maken dat hun gegevens naar de LLM-server worden verzonden. Het is een privé en veilige manier om AI te gebruiken.

Om de lokale LLM-modellen te gebruiken, heb je 2-10 GB ruimte op je computer nodig, afhankelijk van de variant die je gaat gebruiken. Enkele van de ondersteunde LLM’s zijn Llama van Meta, Phi-2 van Microsoft, Gemma van Google, Vicuna, Mixtral van Mistral AI, enz. U kunt deze taalmodellen gebruiken in plaats van de Aria AI van Opera en terugschakelen naar Aria AI wanneer u maar wilt wil.

De functie is momenteel alleen beschikbaar in de ontwikkelaarsstream van Opera One. Hier leest u hoe u de lokale AI-modellen in Opera One Developer kunt activeren en gebruiken.

Download Opera One-ontwikkelaar

Als u al over Opera One Developer beschikt, kunt u dit gedeelte overslaan en direct verdergaan met het gebruik van de lokale LLM-modellen.

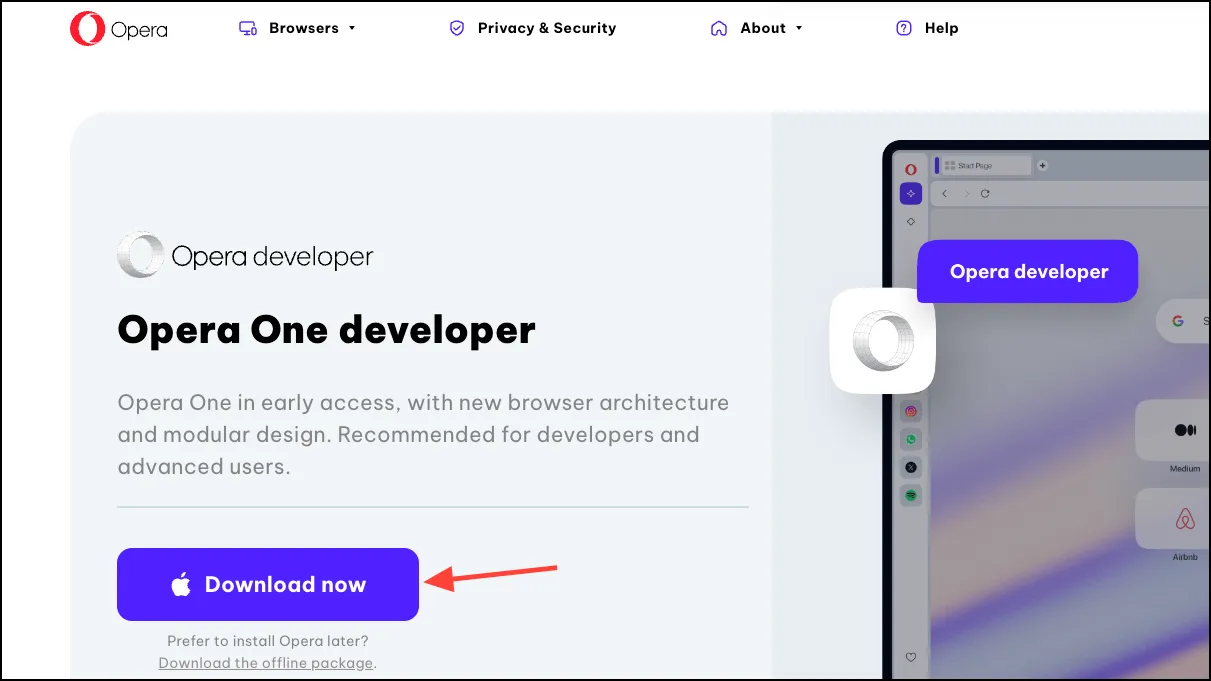

- Ga naar deze link om Opera One Developer te downloaden. Scroll naar beneden en klik op ‘Nu downloaden’ op de Opera One Developer-tegel.

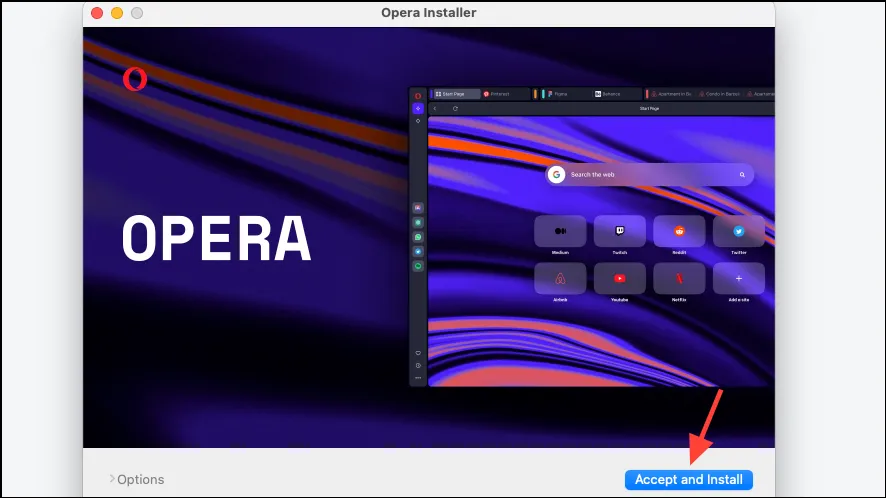

- Open het bestand zodra het is gedownload en voer het installatieprogramma uit.

- Klik op ‘Accepteren en installeren’ en volg daarna de instructies op uw scherm om de browser te installeren.

Lokaal AI-model instellen

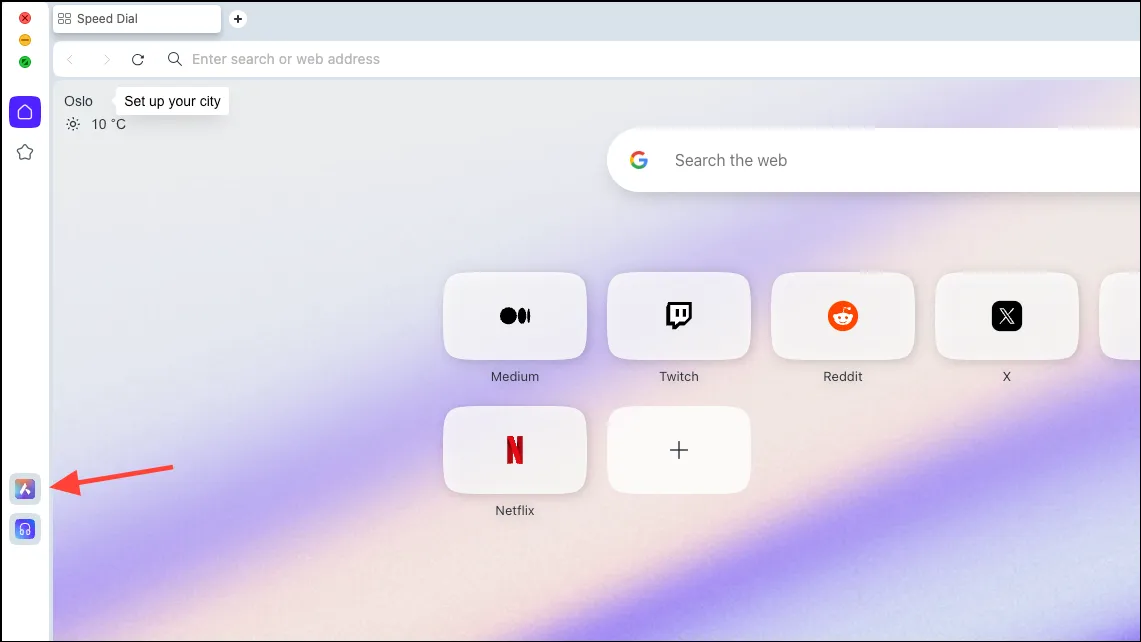

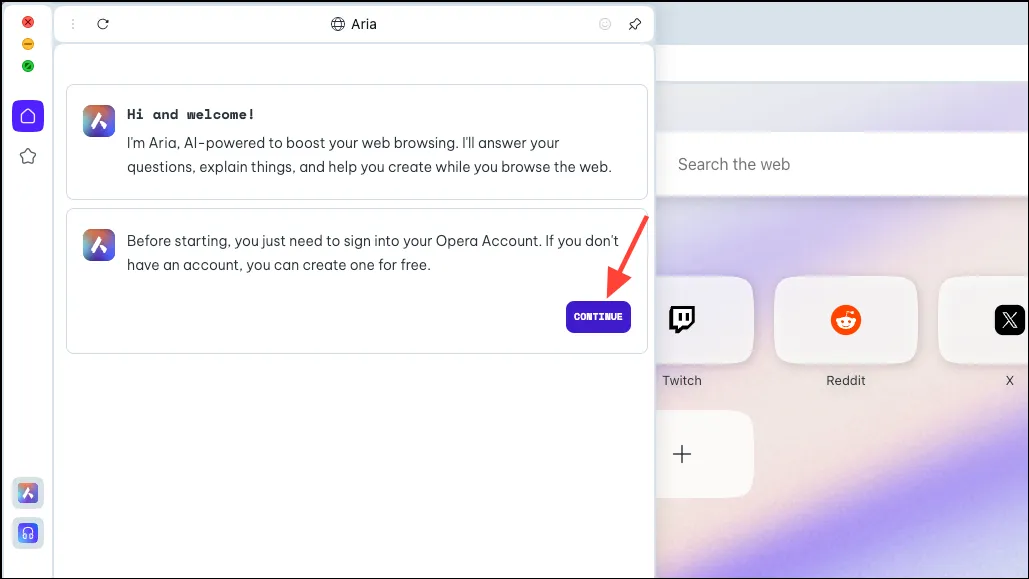

- Zodra de browser is gedownload, klikt u op het ‘Aria AI’-pictogram in de linkerzijbalk.

- Klik op ‘Doorgaan’ om door te gaan.

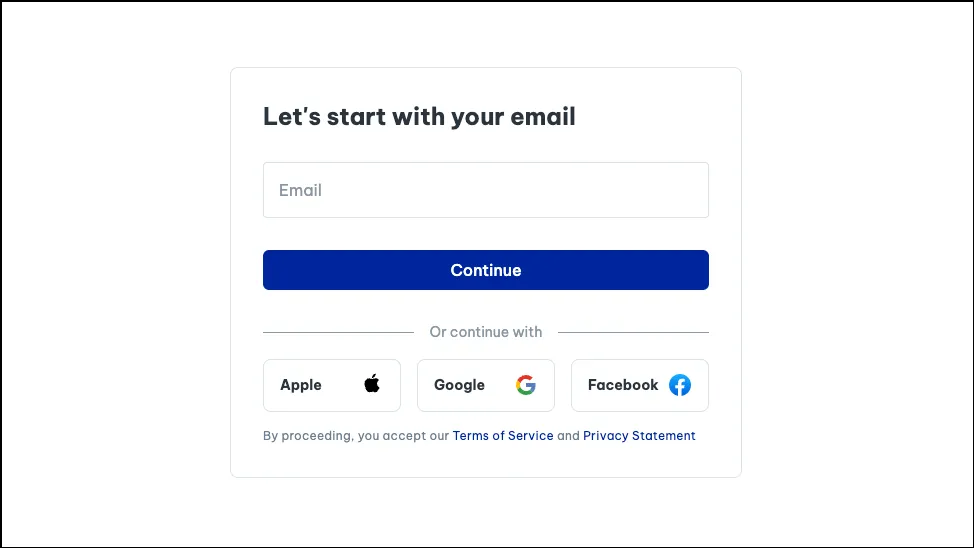

- Als u Aria voor de eerste keer gebruikt, moet u zich aanmelden voor een gratis Opera-account om het te kunnen gebruiken. U kunt uw e-mailadres of uw Apple-, Facebook- of Google-account gebruiken om een Opera-account aan te maken.

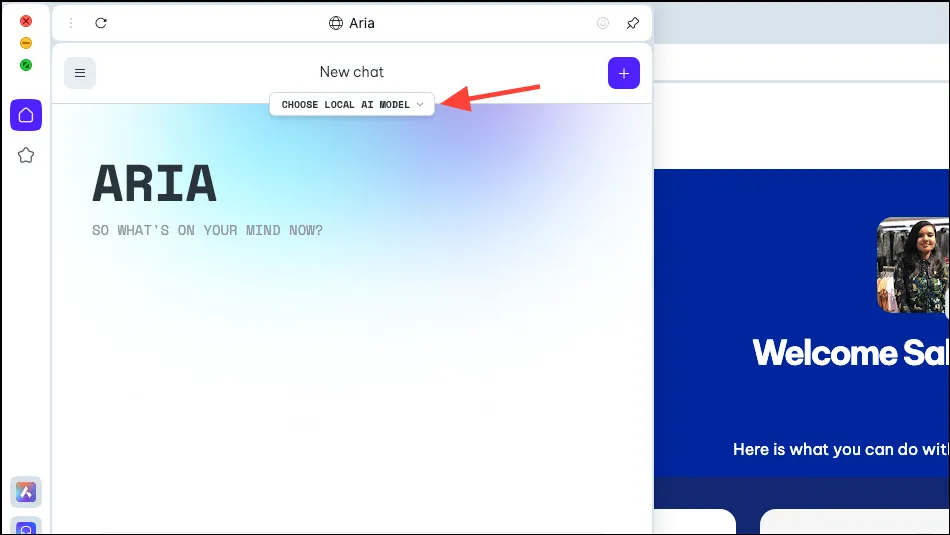

- Zodra uw account is aangemaakt, kunt u met Aria chatten.

- Nu zie je in het Aria-paneel een optie ‘Kies lokaal AI-model’. Klik erop.

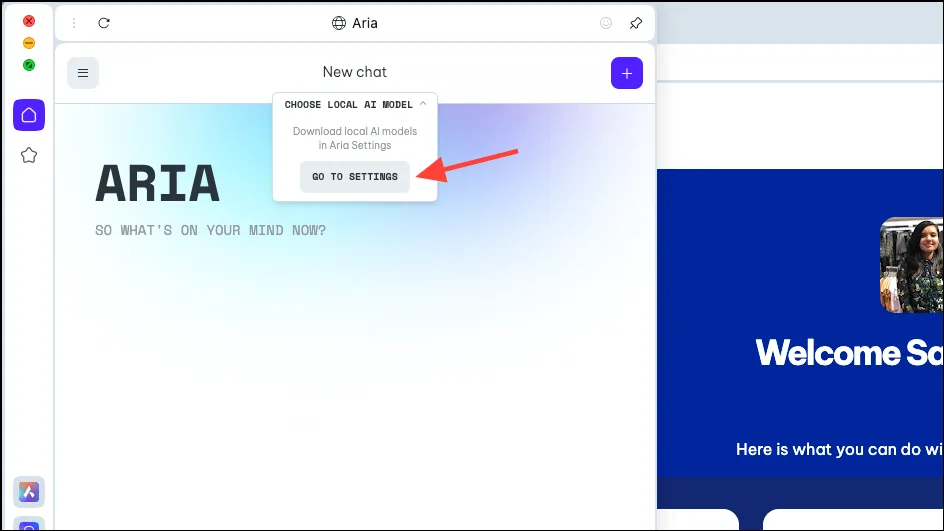

- Selecteer ‘Ga naar Instellingen’ in het vervolgkeuzemenu.

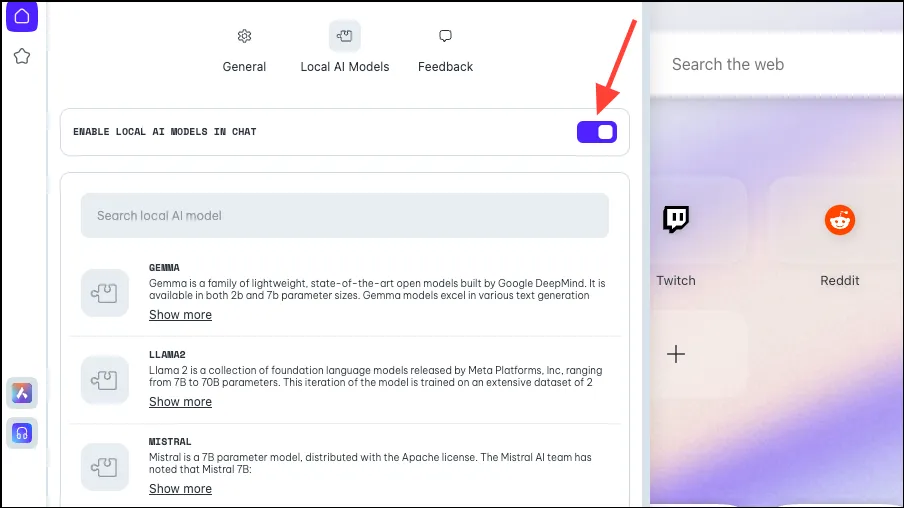

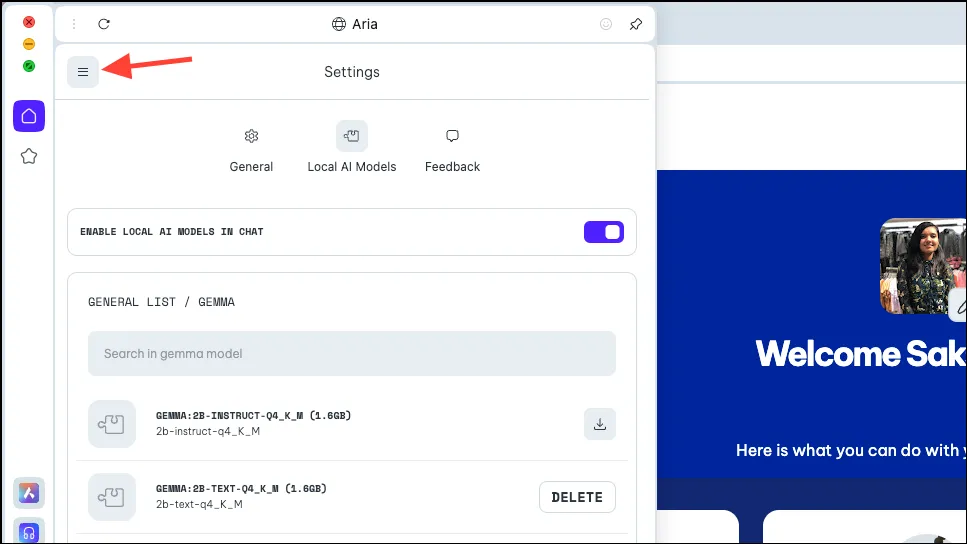

- Zorg ervoor dat de schakelaar voor ‘Lokale AI inschakelen in chats’ is ingeschakeld.

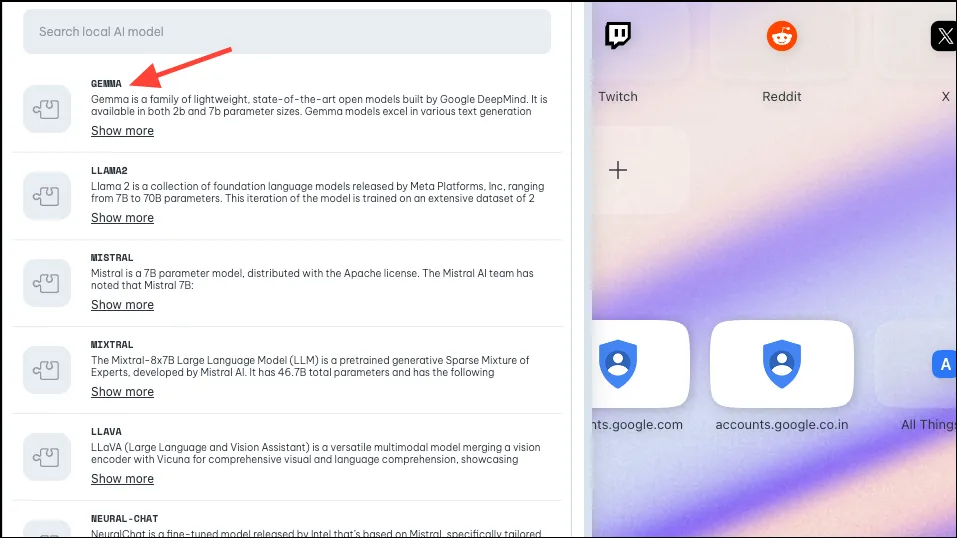

- Kies vervolgens het model dat u wilt downloaden voor lokaal gebruik, door erop te klikken of ernaar te zoeken. Zoals hierboven vermeld, heeft Opera ondersteuning geïmplementeerd voor ongeveer 50 modelfamilies met verschillende varianten, wat het totaal op 150 brengt.

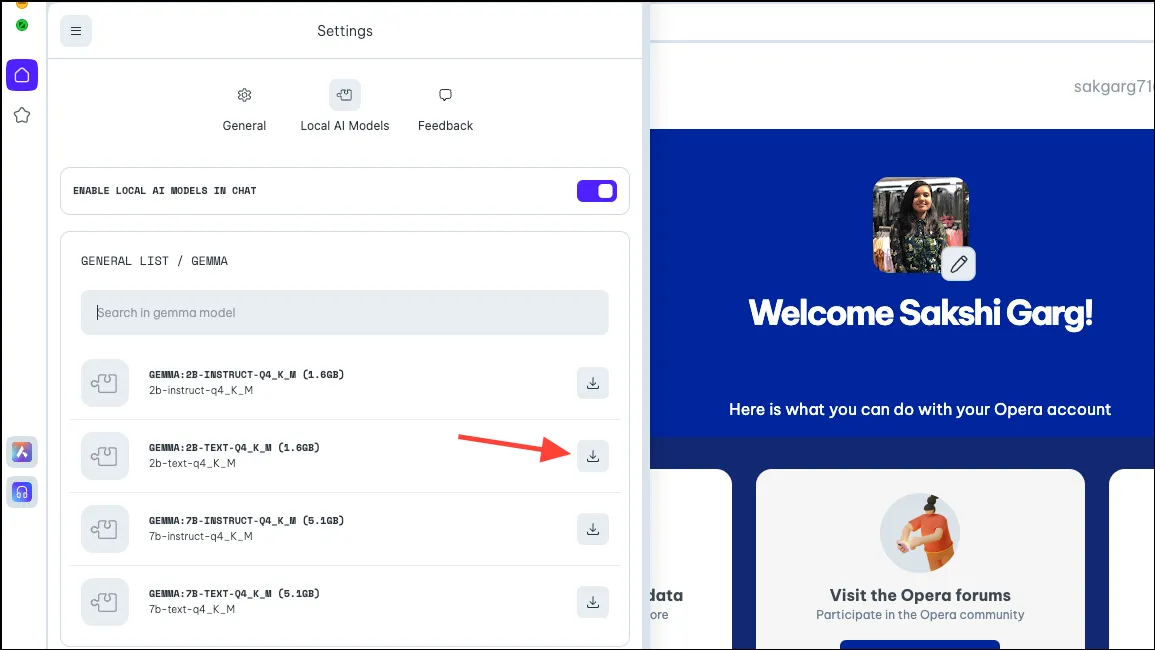

- Als u op sommige modellen klikt, zoals Gemma van Google, krijgt u dus voor sommige modellen vier verschillende varianten. Download het model dat u wilt gebruiken. Voor deze handleiding downloaden we het 2B-tekstmodel van Gemma. Klik rechts op de knop ‘Downloaden’. Voordat u het downloadt, kunt u zien hoeveel ruimte het model op uw pc nodig heeft.

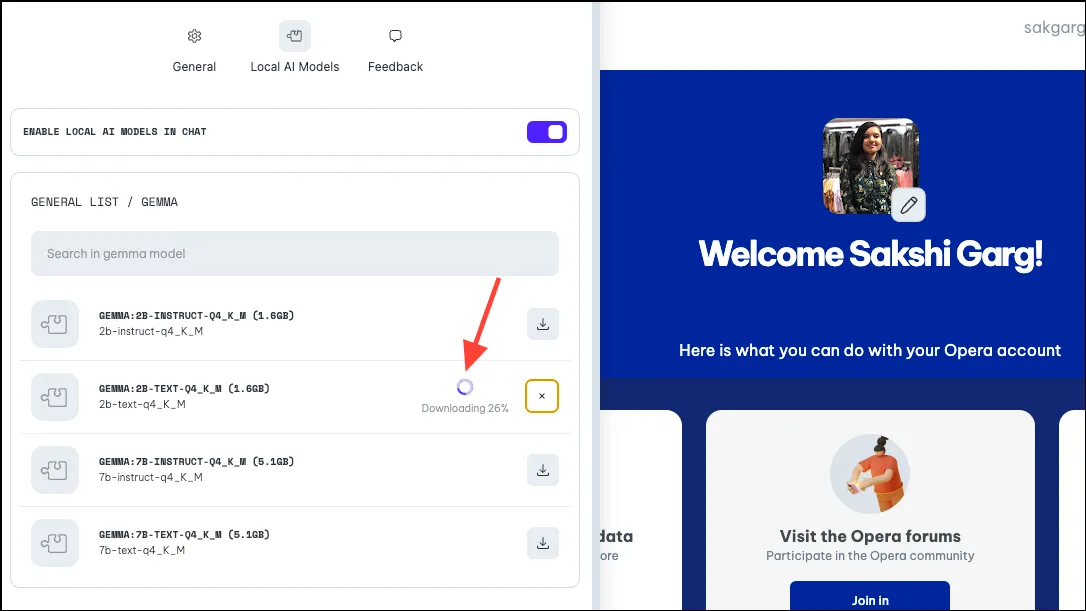

- Het downloaden kan enige tijd duren, afhankelijk van de modelgrootte en uw internetverbinding. Je kunt de voortgang van de download ernaast zien.

Het lokale AI-model gebruiken

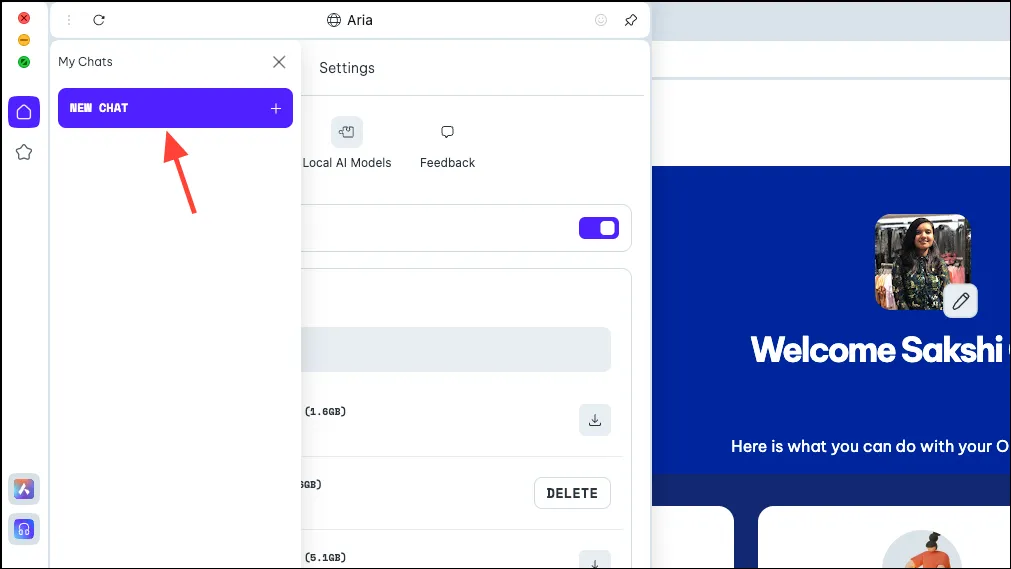

- Zodra het model is gedownload, klikt u op het pictogram ‘Menu’ linksboven in het paneel.

- Selecteer ‘Nieuwe chat’ in het menu dat verschijnt.

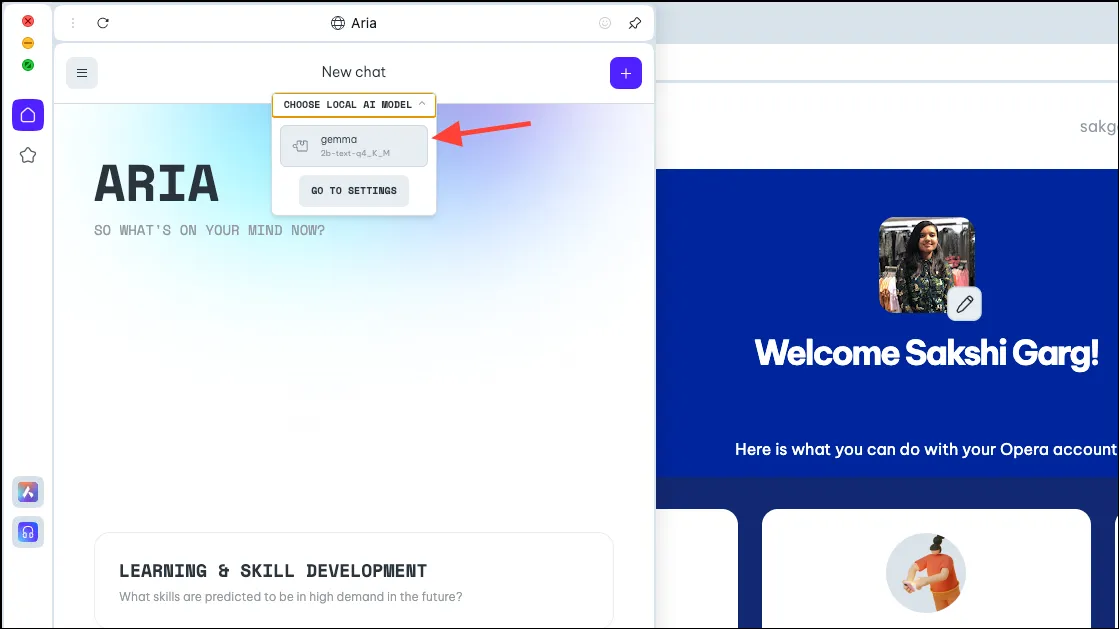

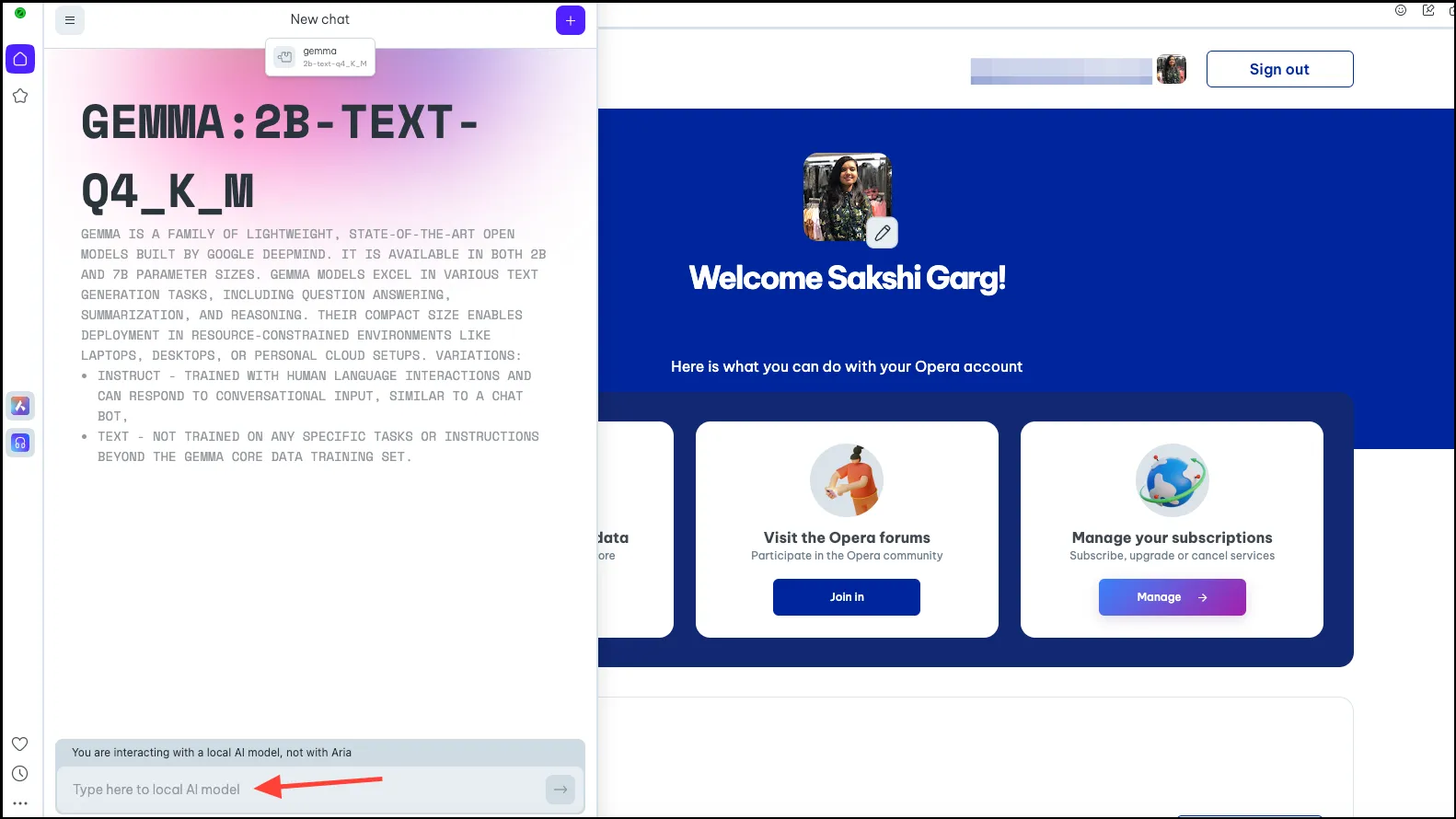

- Klik opnieuw op de optie ‘Kies lokaal AI-model’ bovenaan en selecteer het model dat je zojuist hebt gedownload, Gemma in ons geval, in het vervolgkeuzemenu.

- U wordt nu overgeschakeld naar het lokale AI-model van uw keuze. Typ uw prompt in de promptbalk en stuur deze naar de AI om uw lokale interacties te starten.

- Je chats met het Lokale AI-model zullen beschikbaar zijn in de chatgeschiedenis, net zoals je chats met Aria. Je kunt de chats ook hernoemen voor een betere organisatie.

- Op dezelfde manier kunt u meerdere lokale AI-modellen downloaden en gebruiken, maar onthoud dat elk ergens tussen de 2 en 10 GB ruimte op uw computer nodig heeft.

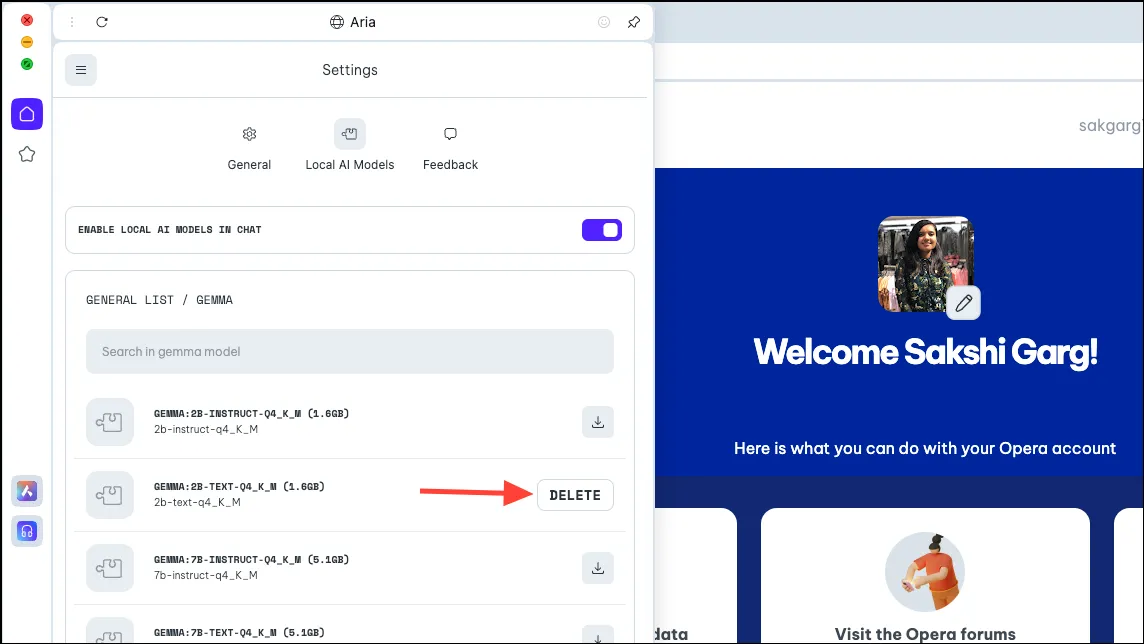

- Om het model van uw pc te verwijderen, navigeert u naar dezelfde instellingen waar we het model eerder hebben gedownload, dat wil zeggen

Aria>Settings>Local AI Models>[Downloaded Model]. Klik vervolgens op de knop ‘Verwijderen’.

Schakel terug naar Aria

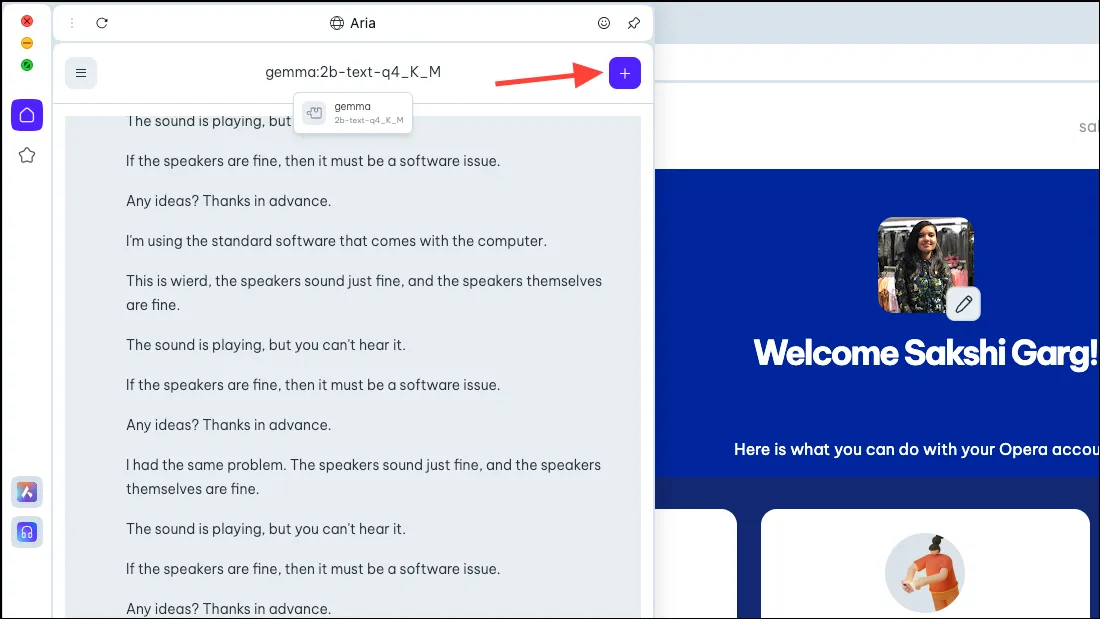

- Om terug te schakelen naar Aria, start u eenvoudig een nieuwe chat met de AI. Klik op het ‘+’-pictogram in de rechterbovenhoek.

- De nieuwe chat begint met Aria zelf.

Het is heel spannend om lokale AI-modellen in de Opera One-browser te kunnen gebruiken, en niet alleen vanuit het oogpunt van beveiliging en privacy. Hoewel het in de beginfase allemaal heel eenvoudig is, zijn de potentiële toekomstige gevallen nogal spannend. Een browser met een lokale AI zou kunnen betekenen dat deze uw historische invoer met al uw gegevens zou kunnen gebruiken; hoe spannend zou dat zijn! En het team van Opera onderzoekt die mogelijkheid.

Maar zelfs zonder toekomstige mogelijkheden zijn lokale AI’s een geweldige zet voor gebruikers die zich zorgen maken over hun gegevens en chats met de AI die op hun servers wordt opgeslagen. Er zijn een aantal geweldige LLM’s die je zou kunnen verkennen, zoals Llama voor coderen, Phi-2 voor uitstekende redeneervaardigheden en Mixtral voor taken zoals het genereren van tekst, het beantwoorden van vragen, enz.

Geef een reactie