Als u Large Language Models of LLM’s op uw computer wilt uitvoeren, is een van de gemakkelijkste manieren om dat te doen via Ollama. Ollama is een krachtig open-sourceplatform dat een aanpasbare en gemakkelijk toegankelijke AI-ervaring biedt. Het maakt het eenvoudig om verschillende LLM’s te downloaden, installeren en ermee te interacteren, zonder dat u afhankelijk bent van cloudgebaseerde platforms of technische expertise nodig hebt.

Naast de bovenstaande voordelen is Ollama vrij lichtgewicht en wordt het regelmatig bijgewerkt, wat het zeer geschikt maakt voor het bouwen en beheren van LLM’s op lokale machines. U hebt dus geen externe servers of ingewikkelde configuraties nodig. Ollama ondersteunt ook meerdere besturingssystemen, waaronder Windows, Linux en macOS, evenals verschillende Docker-omgevingen.

Ollama downloaden en installeren

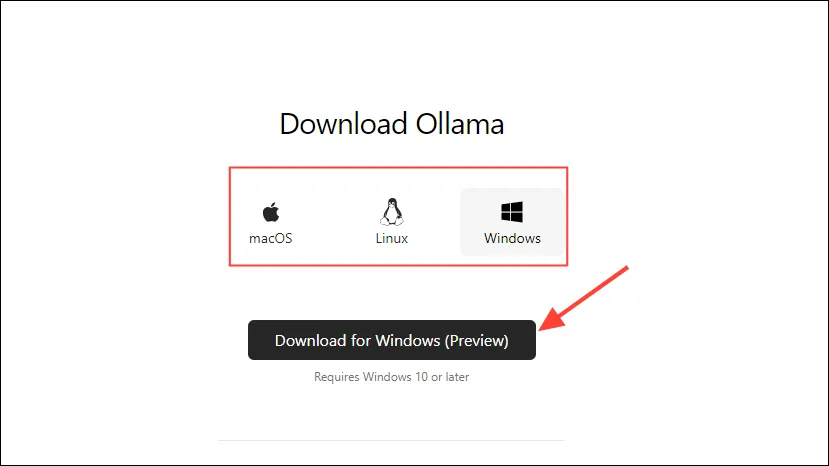

- Ga eerst naar de Ollama-downloadpagina en selecteer uw besturingssysteem voordat u op de knop ‘Downloaden’ klikt.

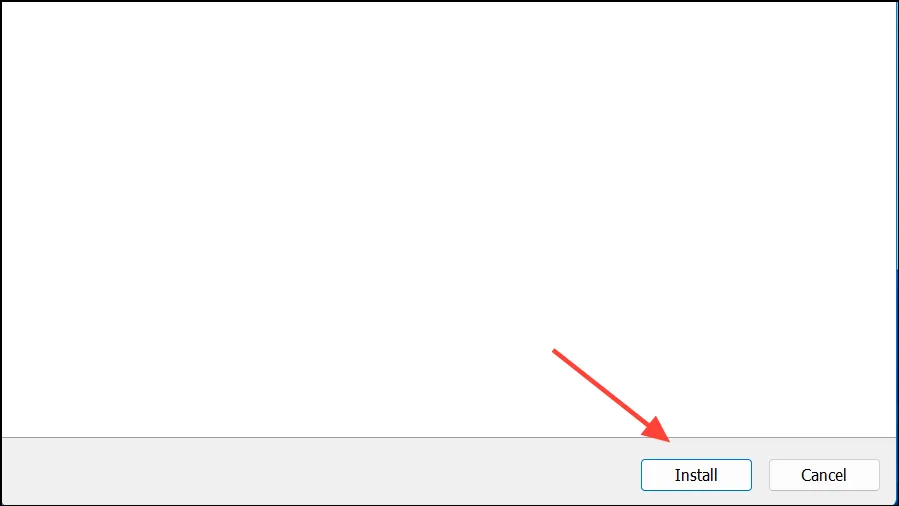

- Zodra de download is voltooid, opent u het en installeert u het op uw machine. Het installatieprogramma sluit automatisch nadat de installatie is voltooid.

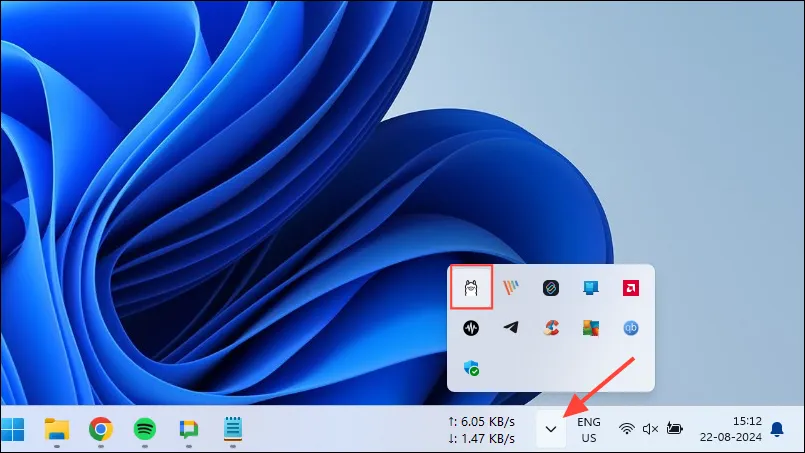

- In Windows kunt u controleren of Ollama actief is door op de overloopknop op de taakbalk te klikken om verborgen pictogrammen weer te geven.

Ollama aanpassen en gebruiken

Zodra Ollama op uw computer is geïnstalleerd, moet u als eerste de opslaglocatie voor de gegevens wijzigen. Standaard is de opslaglocatie, C:\Users\%username%\.ollama\modelsmaar omdat AI-modellen vrij groot kunnen zijn, kan uw C-schijf snel vol raken. Om dit te doen,

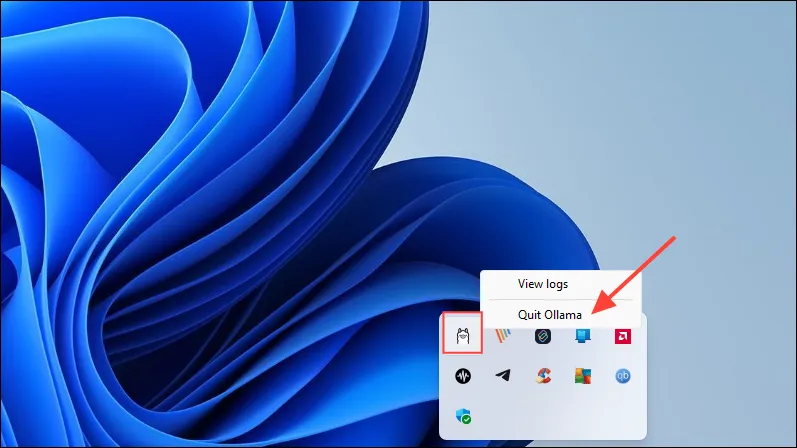

- Klik eerst op het Ollama-pictogram in de taakbalk en klik op ‘Ollama afsluiten’.

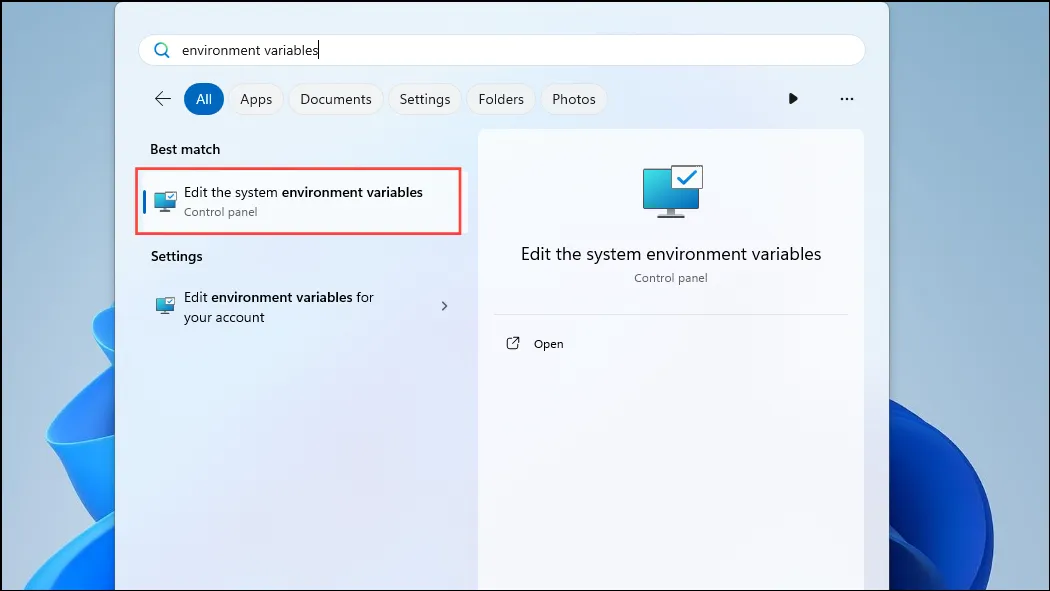

- Zodra Ollama is afgesloten, opent u het menu Start, typt u

environment variables‘De systeemomgevingsvariabelen bewerken’ en klikt u erop.

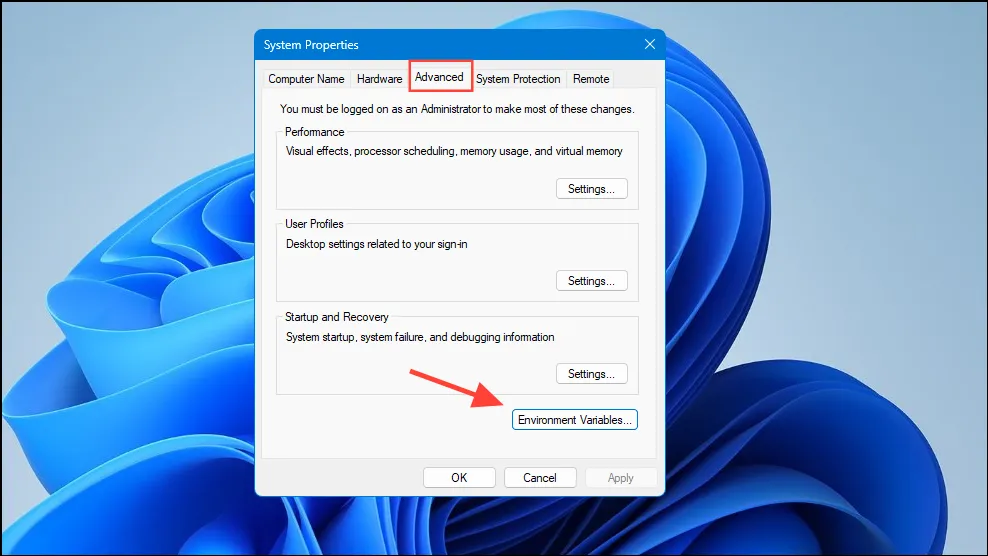

- Wanneer het dialoogvenster Systeemvariabelen wordt geopend, klikt u op de knop ‘Omgevingsvariabelen’ op het tabblad ‘Geavanceerd’.

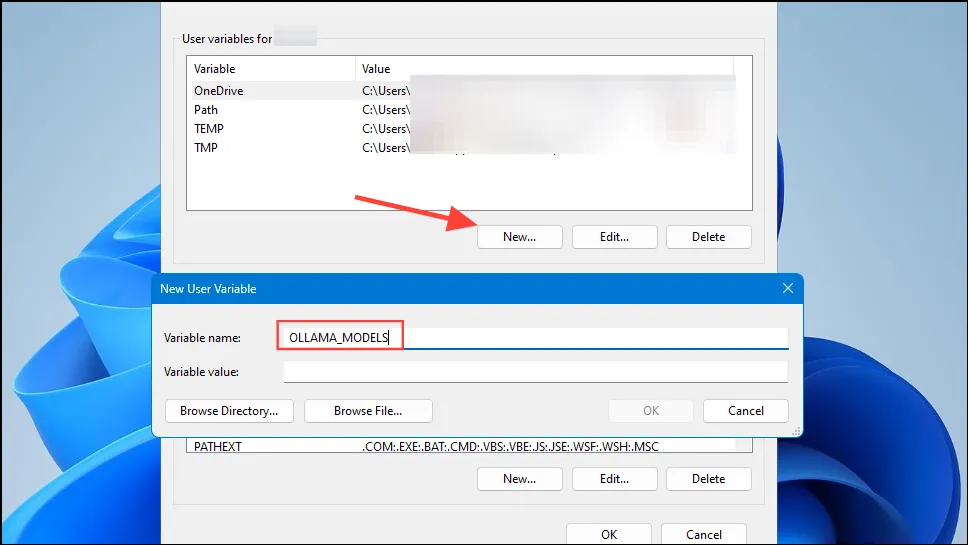

- Klik op de knop ‘Nieuw’ voor uw gebruikersaccount en maak een variabele aan

OLLAMA_MODELSin het veld ‘Variabelenaam’.

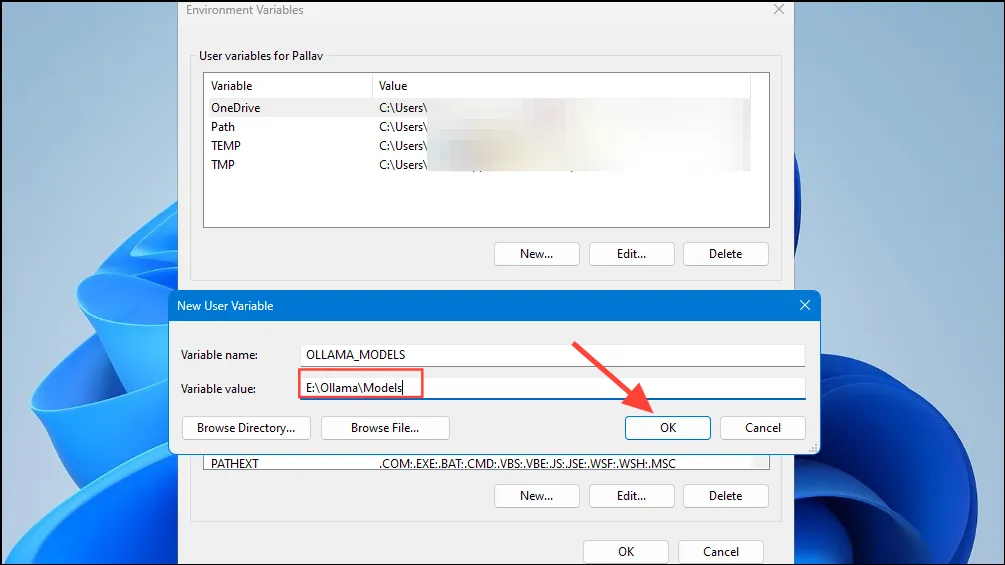

- Typ vervolgens de locatie van de directory waar u wilt dat Ollama zijn modellen opslaat in het veld ‘Variable value’. Klik vervolgens op de knop ‘OK’ voordat u Ollama start vanuit het menu Start.

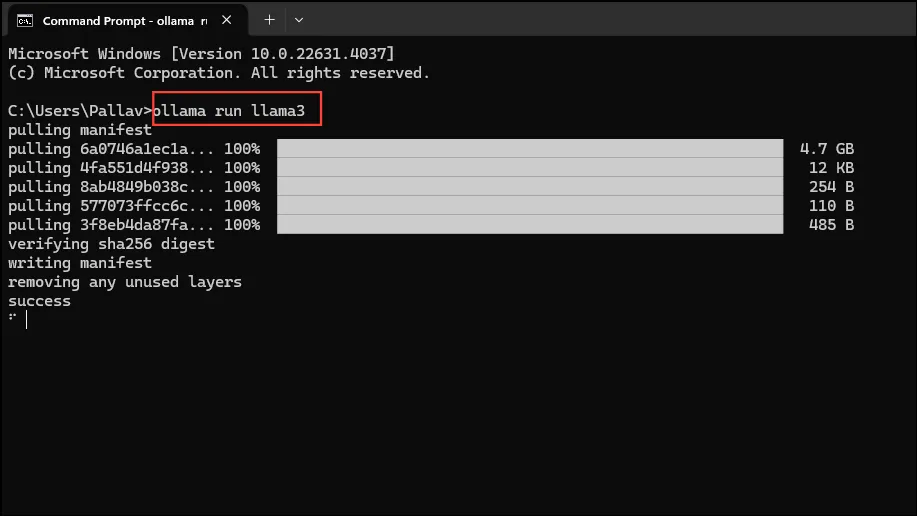

- Nu bent u klaar om Ollama te gaan gebruiken, en u kunt dit doen met Meta’s Llama 3 8B, het nieuwste open-source AI-model van het bedrijf. Om het model uit te voeren, start u een opdrachtprompt, Powershell of Windows Terminal-venster vanuit het menu Start.

- Zodra het opdrachtpromptvenster opent, typt u

ollama run llama3en drukt u op Enter. Het model is bijna 5 GB, dus het downloaden ervan zal tijd kosten.

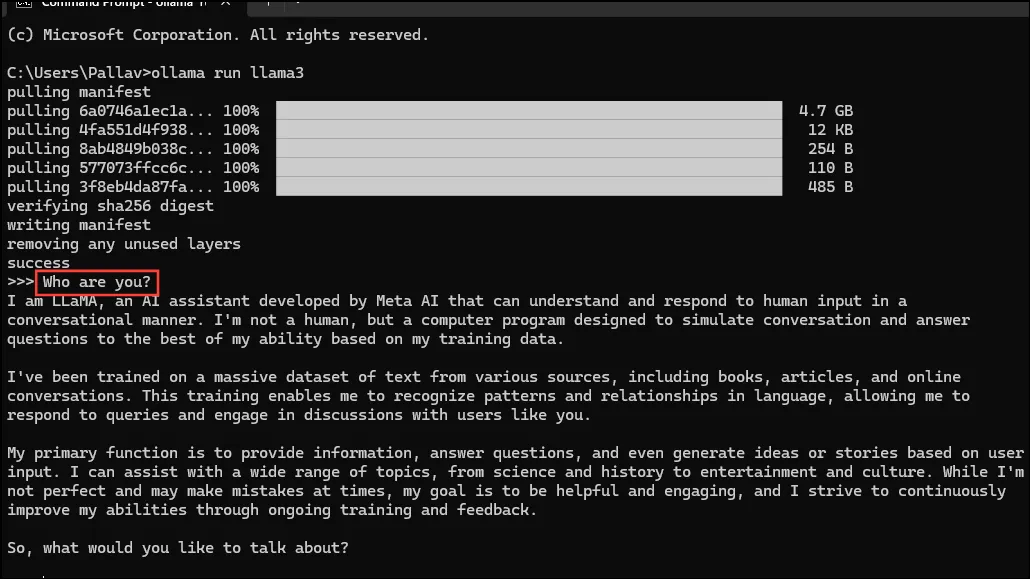

- Zodra de download is voltooid, kunt u Llama 3 8B gebruiken en er direct mee converseren in het opdrachtregelvenster. U kunt bijvoorbeeld het model vragen

Who are you?en op Enter drukken om een antwoord te krijgen.

- Nu kun je het gesprek voortzetten en de AI-modellen vragen stellen over verschillende onderwerpen. Houd er wel rekening mee dat Llama 3 fouten kan maken en hallucinaties kan veroorzaken, dus wees voorzichtig bij het gebruik ervan.

- U kunt ook andere modellen uitproberen door de Ollama modelbibliotheekpagina te bezoeken. Daarnaast zijn er verschillende opdrachten die u kunt uitvoeren om verschillende functionaliteiten uit te proberen die Ollama biedt.

- U kunt ook verschillende bewerkingen uitvoeren terwijl u een model uitvoert, zoals sessievariabelen instellen, modelinformatie weergeven, een sessie opslaan en meer.

- Met Ollama kunt u ook profiteren van multimodale AI-modellen om afbeeldingen te herkennen. Het LLava-model kan bijvoorbeeld afbeeldingen herkennen die zijn gegenereerd door DALLE-3. Het kan afbeeldingen gedetailleerd beschrijven.

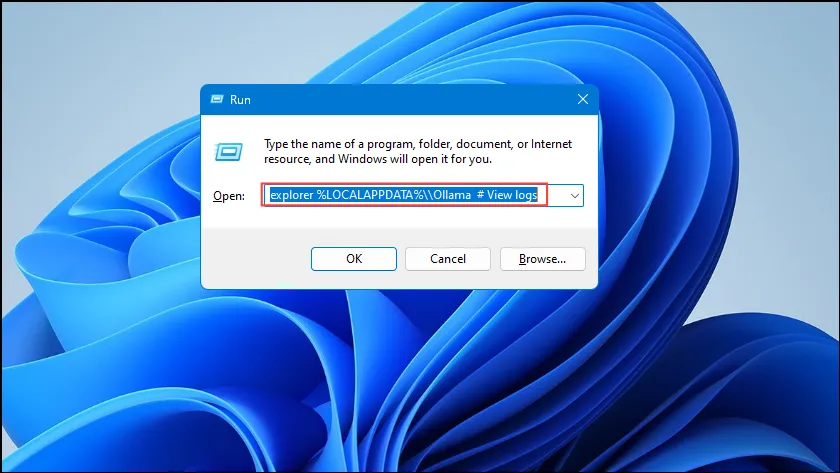

- Als u fouten tegenkomt tijdens het uitvoeren van Ollama, kunt u de logs controleren om erachter te komen wat het probleem is. Gebruik de

Win + Rsnelkoppeling om het dialoogvenster Uitvoeren te openen en typ vervolgensexplorer %LOCALAPPDATA%\\Ollama # View logserin voordat u op Enter drukt.

- U kunt ook andere opdrachten zoals

explorer %LOCALAPPDATA%\\Programs\\Ollamaen gebruikenexplorer %HOMEPATH%\\.ollamaom de opslaglocatie van de binaire bestanden, het model en de configuratie te controleren.

Dingen om te weten

- Ollama detecteert automatisch uw GPU om AI-modellen uit te voeren, maar in machines met meerdere GPU’s kan het de verkeerde selecteren. Om dit te voorkomen, opent u het Nvidia Control Panel en stelt u Display in op ‘Nvidia GPU Only’.

- De weergavemodus is mogelijk niet op elk apparaat beschikbaar en ontbreekt ook wanneer u uw computer op externe beeldschermen aansluit.

- In Windows kunt u met Taakbeheer controleren of Ollama de juiste GPU gebruikt. Taakbeheer geeft het GPU-gebruik weer en laat u weten welke GPU wordt gebruikt.

- Hoewel het installeren van Ollama op macOS en Linux iets anders verloopt dan op Windows, is het proces om LLM’s uit te voeren vrijwel hetzelfde.

Geef een reactie