Herinner je je de voice demo voor GPT-4o van OpenAI van een paar maanden geleden nog die de wereld deed schudden met zijn gelijkenis met een mens? Je weet wel, die je even deed vergeten dat je met een AI praatte en die veel mensen zelfs deed denken aan Scarlett Johanssons AI-personage uit de film Her (en ook kritiek kreeg op hetzelfde).

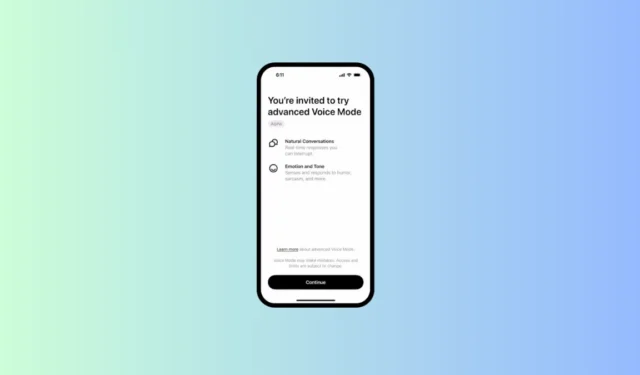

OpenAI begint het eindelijk uit te rollen in Alpha voor een klein aantal ChatGPT Plus-gebruikers, zoals het bedrijf deelde op X. Hoewel het bedrijf aanvankelijk plannen had om de uitrol in juni te starten, werd het uitgesteld om veiligheidsredenen en om ervoor te zorgen dat het “de lat van [OpenAI] voor lancering kon halen”. Daarom was het bedrijf druk bezig het model te verbeteren met een team van externe red teamers, zodat het bepaalde content zou detecteren en weigeren.

We beginnen met het uitrollen van de geavanceerde Voice Mode naar een kleine groep ChatGPT Plus-gebruikers. De geavanceerde Voice Mode biedt natuurlijkere, realtime gesprekken, stelt u in staat om op elk moment te onderbreken en voelt en reageert op uw emoties. pic.twitter.com/64O94EhhXK

— OpenAI (@OpenAI) 30 juli 2024

Nu beginnen sommige betalende gebruikers toegang te krijgen tot het model in hun ChatGPT-app, maar op dit moment blijft de toegang tot de alfaversie beperkt. Het bedrijf zegt dat het van plan is om geleidelijk toegang uit te rollen naar meer gebruikers en het later in de herfst naar alle betalende gebruikers te brengen.

Er lijkt geen manier te zijn om toegang tot de Advanced Voice Mode aan te vragen. Als je op de lijst staat van het kleine aantal gebruikers dat toegang krijgt tot de alpha, ontvang je een e-mail met instructies en een melding in je ChatGPT-app om de Voice Mode uit te proberen.

De Advanced Voice Mode kan alleen spreken in de 4 vooraf ingestelde stemmen: Juniper, Amber, Cove en Breeze. Opvallend is dat OpenAI Sky heeft verwijderd, degene die klonk als Scarlett Johansson, kort nadat de demo werd uitgebracht op het Spring-evenement en de acteur brieven naar het bedrijf stuurde met de vraag hoe de stem was gemaakt (waarop OpenAI blijkbaar nooit heeft gereageerd). Sky maakt nog steeds geen deel uit van de selectie, zo lijkt het.

ChatGPT-4o kan ook geen outputs leveren in een andere stem dan die in de preset om de privacy van de gebruiker te beschermen. Er zijn ook guardrails om verzoeken voor gewelddadige of auteursrechtelijk beschermde content te blokkeren.

Als je toegang hebt tot de geavanceerde Voice Mode in je ChatGPT-app, ga dan door en probeer het eens. Hoewel het niet alles kan wat in de demo’s wordt getoond totdat het ook zijn visiemogelijkheden verwerft, lijkt het nog steeds behoorlijk indrukwekkend, volgens enkele video’s die zijn gedeeld door gebruikers die toegang hebben.

Geef een reactie